Các thuật ngữ LLM quan trọng mà Developer nên biết

23 Jun, 2025

Hướng nội

AuthorNắm vững thuật ngữ như Parameters, Tokens, Context Size, Temperature, ... giúp bạn tận dụng tối đa sức mạnh của LLM và tối ưu ouput đầu ra

Mục Lục

Khi làm việc với các Large Language Model (LLM), chúng ta thường xuyên bắt gặp những thuật ngữ như "Parameters", "Context Size", "Tokens", "Temperature",... Hiểu rõ những khái niệm này không chỉ giúp chúng ta giao tiếp hiệu quả hơn với mô hình mà còn là chìa khóa để tối ưu hóa hiệu suất và nhận output đầu ra đúng như mong muốn.

Bài viết này sẽ giúp bạn dễ dàng nắm bắt được các thuật ngữ quan trọng khi sử dụng LLM.

1. Parameter

Khi bạn bắt gặp một model được gắn nhãn 70B, điều đó nghĩa là nó có 70 tỷ tham số.

- Khái niệm: Tham số (parameters) là các trọng số (weights) và độ lệch (biases) mà mạng nơ-ron học được trong quá trình huấn luyện. Số lượng tham số càng lớn, model càng có khả năng nhận diện và xử lý các mẫu dữ liệu phức tạp, đồng nghĩa với việc model "thông minh" hơn. Ví dụ, Grok-1 với 314 tỷ tham số là minh chứng cho một model cực kỳ phức tạp.

- Hiệu năng & Chi phí: Model càng lớn (nhiều tham số) thì chất lượng đầu ra thường tốt hơn, nhưng đồng thời yêu cầu phần cứng mạnh để thực thi (inference) và chi phí vận hành cao hơn.

- Self-Hosting vs. API: Model 7B có thể chạy trên một GPU cao cấp, phù hợp để tự triển khai (self-hosting). Trong khi đó, model 70B gần như bắt buộc phải sử dụng dịch vụ cloud chuyên dụng (như Vertex AI, SageMaker) hoặc truy cập qua API. Tụi mình đã test thì thấy nếu chạy self-host trên 1 server GPU thì nên lựa chọn những model nhỏ hơn 10B tham số.

- Sự đánh đổi: Chọn giữa model lớn hay nhỏ luôn là bài toán cân bằng giữa chất lượng, tốc độ, chi phí và tính kiểm soát. Nếu bạn cần Model mạnh để xử lý tác vụ phức tạp như generate code, tạo hình ảnh thì bạn buộc phải trả phí để sử dụng API.

2. Token

Token là đơn vị nhỏ nhất mà LLM sử dụng để phân tích và tạo ra văn bản. Trước khi xử lý, toàn bộ input của bạn sẽ được chi nhỏ thành các token.

- Quy ước chung: Trong tiếng Anh, người ta thường ước tính 1 token tương đương khoảng 0.75 từ hoặc 4 ký tự. Đây là một con số hữu ích để có cái nhìn tổng quan ban đầu.

- Thực tế kỹ thuật: Đối với developer, việc dựa vào quy ước trên là không đủ chính xác. Quá trình "tokenization" (phân tách thành token) phức tạp hơn. Một từ có thể là một token (

"model"->["model"]), nhưng cũng có thể bị tách thành nhiều token ("Tokenization"->["Token", "ization"]). Các dấu câu, khoảng trắng, và ký tự đặc biệt cũng thường được tính là các token riêng biệt.

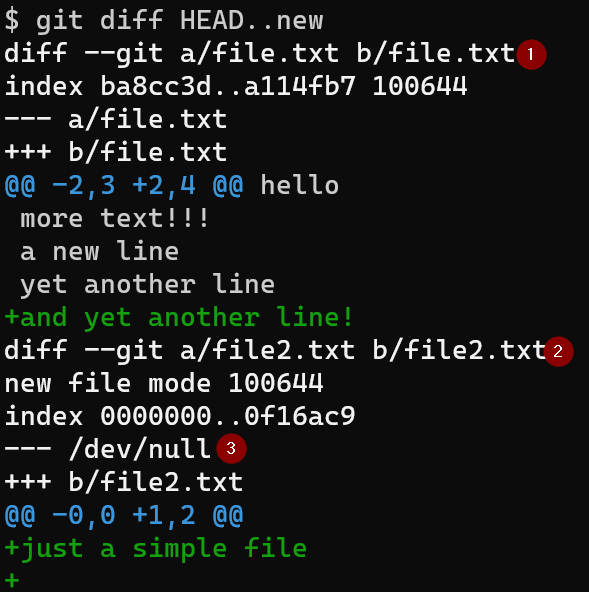

Nhiều LLM như Google Gemini đã cố gắng tối ưu xử lý bằng cách bỏ đi các kí tự xuống dòng không cần thiết trong file code gốc mà bạn gửi lên, tụi mình đã thử và thấy như thế. Nhưng điều này thì có ảnh hưởng gì ? Nó ảnh hưởng đến file diff mà bạn nhận về, hoàn toàn không khớp với file code gốc ban đầu, dẫn đến việc bạn apply diff vào lộn dòng.

3. Context Window (hay Context Length)

Context window (hay context length) là số token tối đa mà model có thể “ghi nhớ” trong một lần xử lý, bao gồm cả phần prompt và câu trả lời.

Ví dụ: GPT-3.5 hỗ trợ tối đa 4096 token, trong khi GPT-4 Turbo có thể lên đến 128k token.

Trong một IDE lập trình AI như Cursor, Context Window chính là "phạm vi hiểu biết" của AI tại một thời điểm. Nó quyết định AI có thể "nhìn thấy" bao nhiêu phần code và cuộc trò chuyện của bạn để đưa ra một câu trả lời thông minh.

Khi bạn chat với AI trong Cursor, những thứ sau đây sẽ được đóng gói và gửi lên cho model (ví dụ: GPT-4) xử lý. Đây chính là "Context":

- Câu lệnh của bạn: "Tìm bug trong function này"

- Đoạn code bạn đang mở: Toàn bộ file

main.pybạn đang xem. - Các file/folder bạn "tag" vào: Khi bạn gõ

@và chọn một file khác (ví dụ:@utils/database.py), nội dung file đó sẽ được đưa vào. - Lịch sử cuộc trò chuyện: Những câu hỏi và câu trả lời trước đó trong cùng một phiên chat.

- Terminal output, Linter warnings...

Giả sử bạn đang làm việc trên một tính năng thanh toán phức tạp và bạn hỏi AI của Cursor:

"Refactor lại hàmhandlePaymenttrong filepaymentController.jsnày để nó clean hơn và xử lý được lỗi khi gọi API thanh toán."

Để trả lời, AI cần "biết" ít nhất:

- Nội dung của file

paymentController.js(giả sử 1500 tokens). - Nội dung của file

apiClient.jsnơi định nghĩa hàm gọi API (giả sử 1000 tokens). - Nội dung của file

errorHelper.jsđể biết cách xử lý lỗi (giả sử 800 tokens). - Lịch sử chat và câu lệnh của bạn (giả sử 200 tokens).

=> Tổng cộng bạn cần: 1500 + 1000 + 800 + 200 = 3500 tokens

4 Temprature

Temperature là một tham số cho phép bạn kiểm soát mức độ ngẫu nhiên trong câu trả lời của mô hình, thường nằm trong khoảng từ 0 đến 2. Nói cách khác, Temperature giúp bạn điều chỉnh xem câu trả lời của AI sẽ an toàn, dễ đoán hay sáng tạo và đa dạng hơn.

Chúng ta đã biết rằng LLM tạo ra câu trả lời bằng cách dự đoán từ tiếp theo có xác suất xuất hiện cao nhất. Ví dụ, với câu "Bầu trời hôm nay...", các lựa chọn có thể là:

- "trong xanh" (90%)

- "quang đãng" (8%)

- "thật đẹp" (1,5%)

- "đang bốc cháy" (0,001%)

Khi temperature thấp (ví dụ: 0.1): Mô hình gần như luôn chọn từ có xác suất cao nhất ("xanh"). Kết quả là các câu trả lời rất an toàn, lặp đi lặp lại và thiếu sáng tạo.

Khi temperature cao (ví dụ: 1.5): Mô hình tăng cơ hội cho những từ ít phổ biến hơn như "quang đãng" hay "thật đẹp", thậm chí đôi lúc chọn cả các phương án kỳ lạ như "đang bốc cháy". Kết quả là câu trả lời đa dạng, sáng tạo, nhưng cũng dễ mất kiểm soát và thiếu tin cậy hơn.

Tóm lại, Temperature không làm thay đổi kiến thức của mô hình, mà chỉ tác động đến mức độ ngẫu nhiên khi lựa chọn câu chữ dựa trên những gì đã học.

5. Hallucination

Hallucination là hiện tượng khi một mô hình ngôn ngữ lớn (LLM) tạo ra thông tin không chính xác, không có thật, hoặc không liên quan đến ngữ cảnh được cung cấp, nhưng lại trình bày nó một cách tự tin và mạch lạc như thể đó là sự thật.

Hallucination xảy ra do LLM hoạt động dựa trên dự đoán xác suất chứ không phải cơ sở dữ liệu truy vấn sự thật. Khi nhận câu hỏi, model không đi tìm kiếm thông tin mà chỉ dự đoán token tiếp theo dựa trên các mẫu ngôn ngữ đã học.

Nếu gặp chủ đề thiếu dữ liệu chính xác, model sẽ tự “lấp chỗ trống” bằng những câu trả lời nghe có vẻ hợp lý, ưu tiên sự mạch lạc thay vì tính đúng đắn. Nói đơn giản, AI không biết nó nói sai mà chỉ đang tạo ra văn bản xác suất cao nhất có thể.

Bạn không thể "sửa" Hallucination nhưng có thể áp dụng các kỹ thuật để giảm thiểu và kiểm soát nó.

- Cung cấp Ngữ cảnh (Grounding) - Kỹ thuật RAG: Đây là phương pháp hiệu quả nhất. Thay vì để AI "tự nhớ", hãy cung cấp cho nó "tài liệu tham khảo" ngay trong câu lệnh, kỹ thuật này được gọi là Retrieval-Augmented Generation (RAG).

- Kỹ thuật Prompt Engineering: Thêm các mệnh đề như

"Hãy trả lời dựa trên tài liệu X","Không được bịa đặt thông tin". Thêm vào cuối prompt một câu như"Nếu bạn không chắc chắn, hãy nói là bạn không biết.". - Điều chỉnh Tham số

temperature: Thiết lậptemperature = 0hoặc giá trị thấp (ví dụ: 0.1, 0.2). Mô hình sẽ đưa ra câu trả lời dễ đoán, an toàn và bám sát vào các thông tin có xác suất cao nhất.

6. Kết luận

Vậy là chúng ta đã cùng điểm qua khái niệm của 5 thuật ngữ quan trọng khi làm việc với LLM. Trong thực tế, các khái niệm này không hoạt động riêng lẻ. Bạn thiết kế một prompt bằng Token, đảm bảo nó nằm gọn trong Context Window. Sau đó tinh chỉnh Temperature để kiểm soát độ tin cậy của đầu ra. Tất cả những điều đó nhằm khai thác sức mạnh của hàng tỷ Parameter một cách tối ưu, đồng thời xây dựng các hàng rào kỹ thuật (như RAG) để vô hiệu hóa Hallucination.