Prompt Caching: Tối Ưu Hiệu Suất và Chi Phí Khi Làm Việc Với LLM API

19 May, 2025

Hướng nội

AuthorPrompt Caching là cơ chế lưu trữ (cache) một phần hoặc toàn bộ prompt (bao gồm systemp prompt, hướng dẫn, tài liệu, ...) mà bạn gửi lên LLM API

Mục Lục

Trong thời đại AI bùng nổ, các mô hình ngôn ngữ lớn (LLM) như GPT-4o của OpenAI hay Claude của Anthropic ngày càng được ứng dụng rộng rãi vào chatbot, trợ lý lập trình, tổng hợp tài liệu, phân tích dữ liệu, v.v. Tuy nhiên, khi phát triển ứng dụng LLM, các developer thường gặp phải hai vấn đề lớn: chi phí sử dụng API cao và độ trễ phản hồi lớn khi phải gửi những prompt dài, lặp đi lặp lại nhiều lần.

Prompt Caching (bộ nhớ đệm prompt) là một giải pháp tối ưu hóa mới, giúp giảm đáng kể chi phí và thời gian phản hồi khi làm việc với các LLM API. Bài viết này sẽ giúp bạn hiểu rõ Prompt Caching là gì, hoạt động ra sao, khi nào nên dùng, cách tối ưu, và những lưu ý thực tiễn để tận dụng tối đa sức mạnh của nó.

1. Prompt Caching là gì?

Prompt Caching là cơ chế lưu trữ (cache) một phần hoặc toàn bộ prompt (bao gồm systemp prompt, hướng dẫn, tài liệu, ví dụ, v.v.) mà bạn gửi lên LLM API. Khi bạn lặp lại phần đầu của prompt nhiều lần (prefix), hệ thống sẽ nhớ và chỉ cần xử lý phần mới mà bạn vừa thêm vào (suffix). Nhờ đó, bạn tiết kiệm được chi phí gọi API mà không cần sửa lại code.

Ví dụ thực tế:

- Chatbot hỗ trợ khách hàng: Phần systemp prompt, thông tin sản phẩm, template luôn giống nhau, chỉ thay đổi câu hỏi của người dùng.

- Trợ lý lập trình: Phần tài liệu API, ví dụ code mẫu không thay đổi, chỉ thay đổi đoạn code người dùng nhập vào.

- Q&A tài liệu dài: Phần đầu là toàn bộ tài liệu, phần sau là câu hỏi từng user.

Lợi ích của Prompt Caching:

- Giảm độ trễ: Phản hồi nhanh hơn tới 80% với prompt dài, giúp tăng trải nghiệm người dùng.

- Tiết kiệm chi phí: Giảm tới 90% chi phí cho phần token đã cache, tối ưu ngân sách AI.

- Tăng khả năng mở rộng: Xử lý nhiều request hơn mà không tăng tải backend.

- Tối ưu trải nghiệm: UX Ứng dụng phản hồi tức thì, đặc biệt với chatbot, agent, Q&A tài liệu lớn.

2. Cơ chế hoạt động của Prompt Caching

2.1 Phân tách Prompt thành Prefix và Suffix

- Prefix: Phần đầu prompt, thường là nội dung tĩnh, lặp lại nhiều lần (hướng dẫn, tài liệu, ví dụ, schema…), bạn không nên thay đổi phần cố định này.

- Suffix: Phần thay đổi ở mỗi lần gọi API (câu hỏi, dữ liệu người dùng…), đây là phần sẽ bị thay đổi nên nãy đặt ở cuối prompt.

2.2 Lưu trữ và tra cứu cache

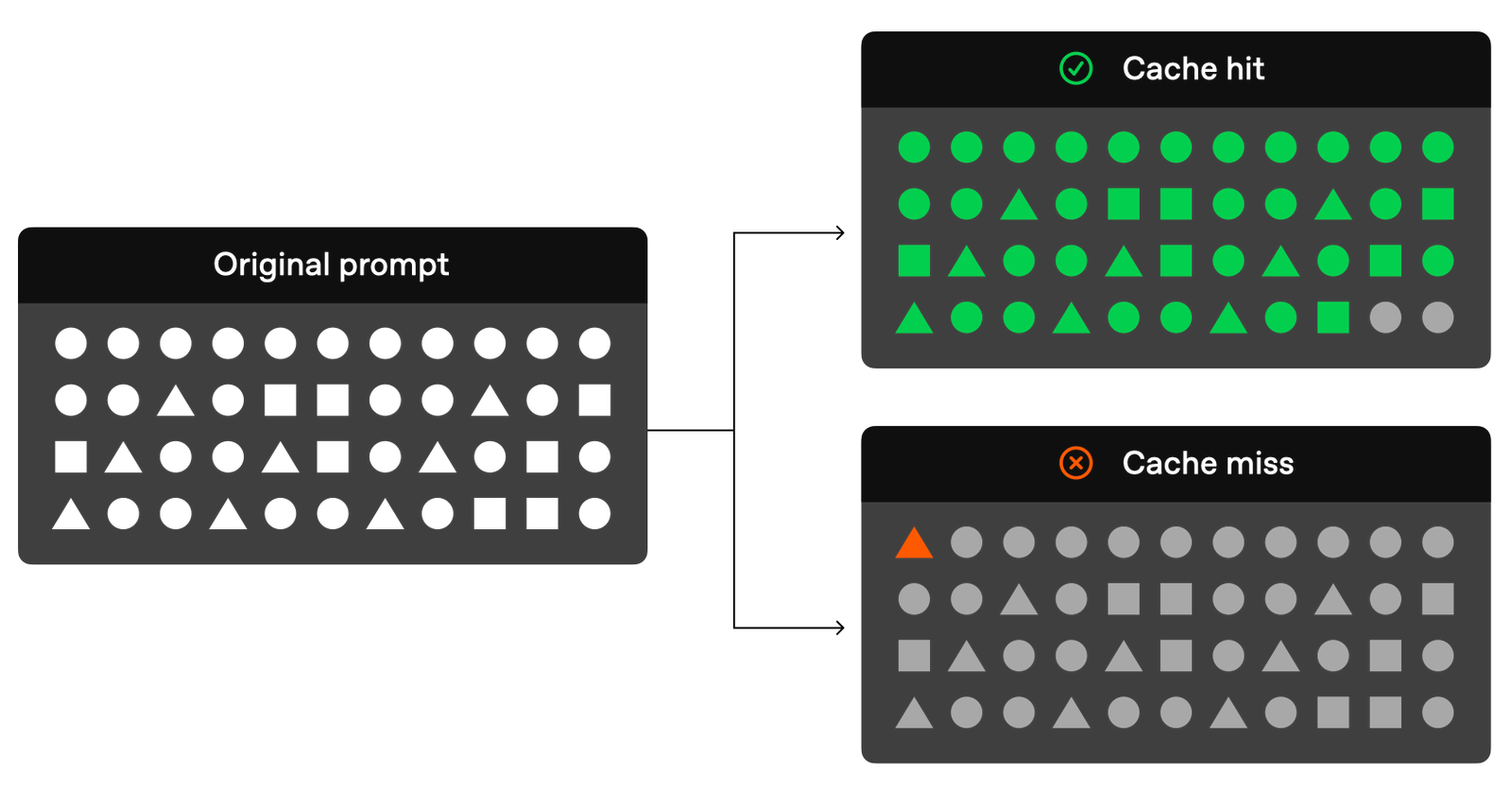

- Khi nhận prompt, API kiểm tra xem prefix đã từng được xử lý chưa (dựa trên hash/tokenization).

- Nếu cache hit (prefix trùng), hệ thống lấy kết quả đã tính toán (key-value states trong transformer) và chỉ xử lý phần suffix mới.

- Nếu cache miss (prefix mới), toàn bộ prompt được xử lý và lưu cache cho lần sau.

2.3 Thời gian lưu cache

- Thường cache tồn tại 5–10 phút khi không hoạt động nào xảy ra hay inactivity (có thể đến 1 giờ vào giờ thấp điểm).

- Nếu trong thời gian này có request với prefix giống hệt, sẽ tận dụng cache.

2.4 Áp dụng với các loại dữ liệu

- Text: Toàn bộ system prompt, user, assistant.

- Image: Nếu encoding và tham số giống nhau.

- Tool/Function Call: Định nghĩa tool/schema nếu không thay đổi.

3. Chi phí cho Cached Token

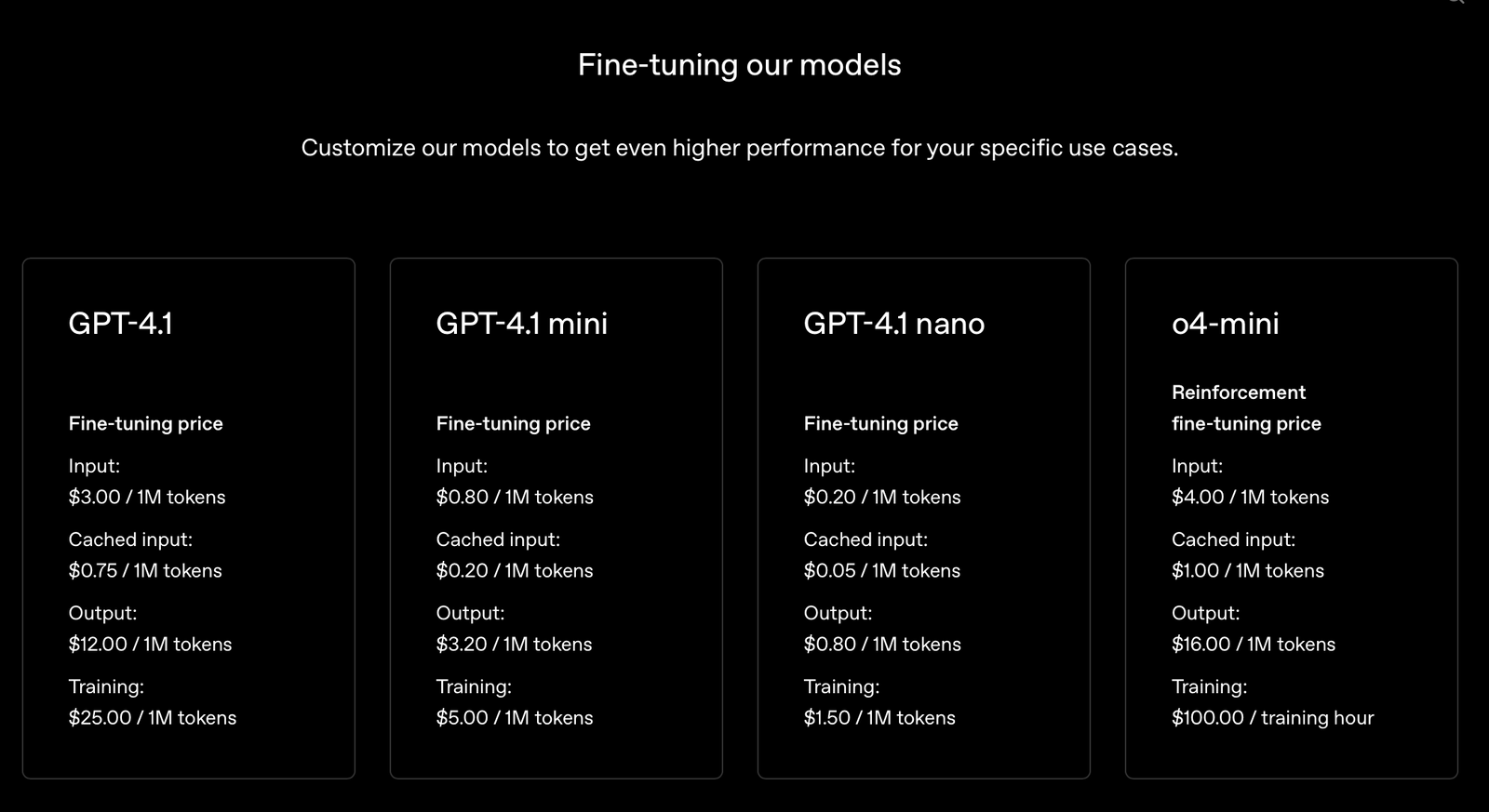

Tuỳ thuộc vào bảng giá của các nhà cung cấp mà cached token sẽ có giá khác nhau, các bạn có thể tham khảo trực tiếp tại website của các API Provider nhé, thông thường nó chỉ bằng 20-30% input token thông thường.

4. Kết luận

Prompt Caching là “vũ khí bí mật” giúp các developer tối ưu hóa hiệu suất và chi phí khi xây dựng ứng dụng AI trên nền tảng LLM API. Chỉ với một số thay đổi nhỏ trong cấu trúc prompt, bạn có thể tiết kiệm hàng chục phần trăm chi phí và tăng tốc độ phản hồi lên nhiều lần.